Deepfake деген не?

Deepfake атауы ағылшын тіліндегі «тереңдетіп оқыту» (deep learning) және «жалған» (fake) сөздерінің қосылуынан тұрады. Бұл — жасанды интеллект негізінде бейнені өзгерту әдісі. Deepfake әлдебір суреттің немесе видеоның үстіне басқа бір суретті немесе видеоны қойып, екеуін біріктіріп жібереді. Ол үшін түрлі алгоритм қолданылады. Жұмыс істеу тәсілін түсіну оңай: жасанды интеллект керек адамның түрлі кейіптегі, түрлі мимика-позадағы мыңдаған фотосы мен видеосын алып (мәселен, YouTube немесе Google-дан), әбден зерттеп, анализ жүргізеді. Содан соң тиісті видеодағы адамның бет-жүзін барынша ұқсатып, алмастыра салады.

Мәселен, мұндай алгоритмдердің бірі — екі нейрожелінің жұмысын қатар алып жүретін GAN алгоритмі (GAN – generative adversarial network). Бір нейрожелі бейнелер ойлап табады, ал екіншісі олардың қайсысы шын, қайсысы өтірік екенін анықтауға тырысады. Біріншісі жалған екені көзге бірден түсетін сурет ұсынса, екінші желі оны дереу тауып қояды. Тиісінше алғашқы нейрожелі келесі бейнелердің фейк екенін табу қиын болуы үшін жұмысын жақсарта түседі. Осылай алма-кезек жарысқан желілер ақыр соңында шын-өтірігін айыру мүмкін емес деуге келетін нәтижені ұсына алады.

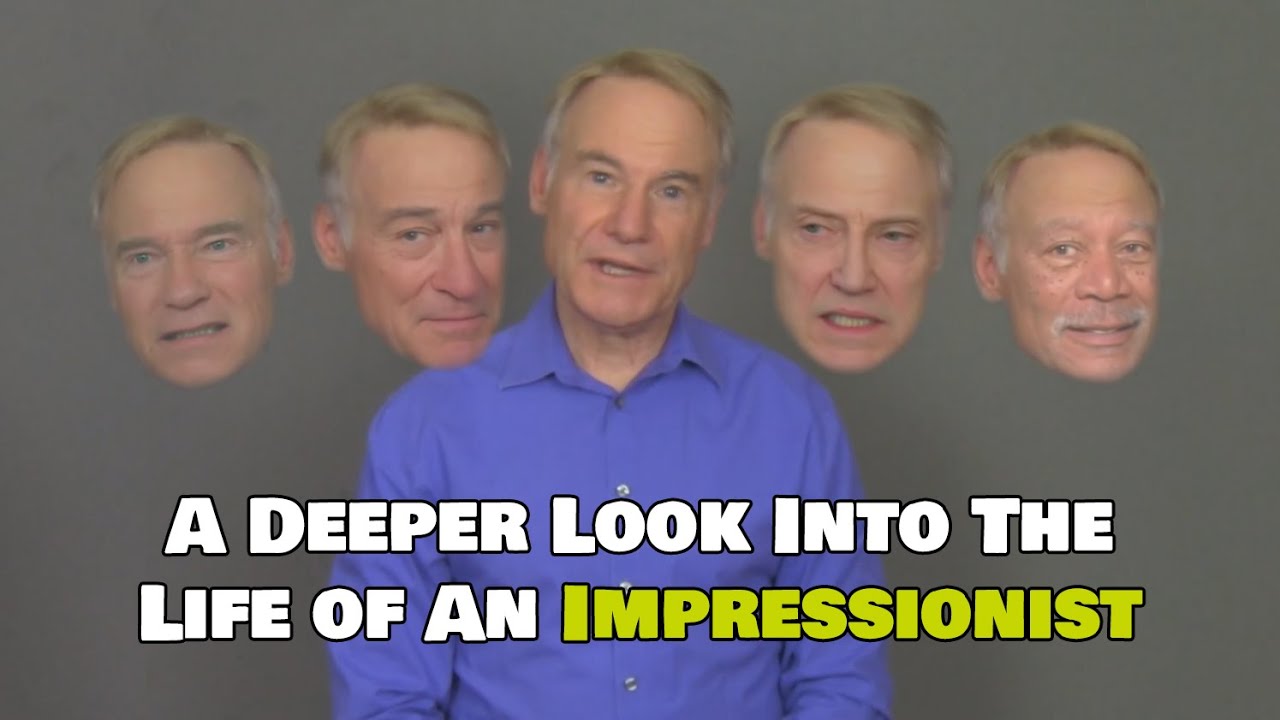

Мысал келтірейік. Төмендегі видеода Джим Мескимен есімді актер Джордж Клуни, Роберт Де Ниро, Арнольд Шварценеггер және басқа да танымал тұлғалардың дауысын салған, ал Sham00k атты қолданушы дауыс иесінің түрін көрсететін deepfake-бағдарлама әзірлеген.

Әрине, deepfake «бүгін-ертең өмірімізге дендеп еніп, экранды қосып қалсаң да, телефонды басып қалсаң да, алдымыздан шыға береді» деуге келмейді. Себебі технологиялардың қуат-әлеуеті терабайт-терабайт мәліметті қорытып, видеоны жылдам синтездеуге мүмкіндік бермей отыр. Дегенмен, сарапшылардың айтуынша, жалған контент адамзат үшін басты проблемаға айналуы мүмкін.

Deepfake қайдан шықты?

Ең бірінші deepfake-технологияны Стэнфорд университетінің студенті Ян Гудфеллоу жасап шыққан деген дерек бар. Қазір бұл бағытты қызығып қолға алған мамандар мен компаниялар баршылық. Олар фото мен видеодағы адамды басқа тұлғаға ауыстырып қана қоймай, дауыс синтездеу технологияларын, сапалы текст жаза алатын алгоритмдерді зерттеп жатыр. Бұл қатарға Украинаның Reflect және Doublicat қолданбаларын немесе Қытайдың Zao технологиясын жатқызуға болады.

Жалпы, адамның түрін, мимикасын, дауысын өзгертуге арналған нейрожелі алгоритмдері баяғыдан бар. Алайда осы бағыттағы жасанды интеллект кейінгі кезде тым қатты дамып кетті: жасалған мультимедиа контентінің өтірік дүние екеніне көз жеткізу кей-кейде тым қиынға соғып жатады.

Интернет-аудитория алғаш рет deepfake-видеомен Reddit әлеуметтік желісінде танысты. 2017 жылы бұл ресурста Deepfakes деген нигі бар қолданушы пайда болып, порновидеолар сала бастады. Бұл роликтер басқа 18+ контенттен видеодағы актерларды танымал жұлдыздармен «ауыстырып қойғанымен» ерекшеленетін.

Атақты актриса Галь Гадот порнороликке бірінші болып «түсті». Әне-міне дегенше Deepfakes видеолары кең таралып, үлкен пікірталас туғызды. Ақыры Reddit роликтерді өшіріп тастады. Басқа сервистер де (олардың қатарында Pornhub та бар) ресурстарына жүктелген жалған «жалаңаш» контентті жойып отырды.

Галь Гадоттан кейін Эмма Уотсон, Тейлор Свифт, Кэти Перри сияқты жұлдыздардың бет-жүзі бар порновидеолар пайда болды.

Скарлетт Йоханссон тіпті өзі туралы роликтерді интернеттен мүлдем жойып жіберуге тырысты, бірақ онысынан түк шыққан жоқ.

Кейінірек актрисаның өзі: Мұның ізіне түсу заң тұрғысынан алғанда өнбес тірлік деп ойлаймын. Себебі интернет — өз-өзін жеп жатқан түпсіз тұңғиық. АҚШ-тағы сайттардан жойсаңыз да, Германияның заң-ережелеріне шамаңыз жетпеуі мүмкін, — деді.

Жалған порноконтент трендтен шыға бастаған кезде deepfake-технология тағы бір шұрқан туғызды. Бұл жолы ел Барак Обаманың видеосын жаппай талқылады. Роликте АҚШ экс-президенті қазіргі Президент Дональд Трампты complete dipshit, яғни, шамалап аударғанда, «барып тұрған есалаң» деп «атады».

Интернетте қазір deepfake бойынша жасалған видеоның түр-түрі бар. YouTube-тегі түрлі канал «Терминатордағы» темір Арнидің орнына Сильвестр Сталлонені қояды, Джек Николсонды Джим Керримен алмастырады, тіпті Дональд Трампқа өз-өзіне сұхбат бергізіп қояды.

Алайда deepfake-контенттің басым бөлігі порно ретінде жасалған. 2019 жылдың қазан айынадағы мәлімет бойынша жалған роликтердің 96%-і осы осы жанрдағы файлдар екен. Жалпы, айына интернетке 15-20 мың deepfake-видео жүктеліп отырады.

DeepFake несімен қауіпті?

Сарапшылар қауіпті екі бағыттан күту керек деп есептейді. Біріншіден, фишинг. Алаяқтардың қолындағы жасанды интеллект аудио немесе видеобайланыс арқылы қандай да бір маңызды шешім қабылдайтын немесе ақша аударуға рұқсат беретін адамның түр-әлпетін, дауысын салып, қылмыс «жасауы» мүмкін.

Әлқисса. 2019 жылдың наурыз айында ағылшын энергетика компаниясының басқарушы директорына Германияда орналасқан бас кеңседен қоңырау келіп түседі. Телефон шалған ең үлкен бастығы екен. Ол бұған Венгриядағы әлдебір фирмаға шұғыл түрде 220 мың фунт-стерлинг (шамамен 240 000 доллар) аударуды бұйырады. Ұлыбританияда отырған директор іске қызу кірісіп кетеді, күмәнданатын жөні де жоқ еді: ұйымдағы нөмірі бірінші адамның дауысын танымай жын ұрып па? Оның үстіне, бастығының поштасынан бұған ақшаны кімге, қайда жіберу керек екені туралы хат келіп қойған еді. Асықтырып жатқанына да таңғалуға болмайды, бірінші рет көріп тұрған жоқ.

Сәлден соң үлкен бастық тағы қоңырау соғып, тез арада екінші аударым жасауды сұрайды. Басқарушы директор, міне, осы жерде іш жияды. Жылдамдатып бастығына өзі телефон шалады да, мұның бәрі өтірік екенін біледі.

Wall Street Journal жариялаған мақалаға сенсек, мұның артында AI-технология қолданған әлдебір ұры тұр екен. Ол осы сәт режимінде бас кеңсе бастығының дауысын айнытпай келтіріп, ағылшын компаниясының ақшасын үпті қылған. Бір қызығы, қылмыс үшін қолданылған бағдарлама керек адамның дауысын сөйлеу мәнері, пунктуациясы, тіпті неміс акцентіне дейін дәл беріпті.

Сарапшылардың айтуынша, бұл оқиға — deepfake-технология арқылы болған алғашқы қылмыс. Әрине, бұдан кейін де түрлі оқиға болған. Дегенмен осындай прецеденттің тіркелуінің өзі қауіпсіздік мәселесіне жаңаша қарау керек екенін көрсетті.

Екінші қатер — жалған ақпарат тарату, «қара PR». Қарсыласының абырой-беделін түсіріп, нұқсан келтіру үшін саяси-коммерция ұйымдары deepfake-технологияларды кеңінен пайдалана алады.

Бір мысал: Принстон, Макс Планк және Стэнфорд университеттерінің мамандары Neural Rendering атты бағдарлама жасады. Бастапқы мақсат игі еді: ғалымдар бұл қолданбаның көмегімен киностудияларға көмектеспек болған-ды. Алайда ақтық нәтиже жаңа қатер сыйлап отыр: Neural Rendering керек адамның бейнесін кез келген тілде кез келген сөзді айтуға «мәжбүрлей» алатын болып шықты. Ол үшін нейрожеліге 40 минуттық керек видеоны жүктеп жіберу жеткілікті екен — бағдарлама роликтегі адамның сөйлеу мәнерін, бет-бейнесін, дауысын әбден зерттейді де, оған айтпаған сөзін айтқыза салады.

Актерлар жұмыссыз қала ма?

2018 жылы Нью-Йорк штатының ассамблеясына тірі немесе қайтыс болған адамның цифр көшірмесін өзінің немесе ұрпақтарының рұқсатынсыз пайдалануға тыйым салатын заң жобасы келіп түсті. Құжаттың қазіргі тағдыры белгісіз, бірақ сол кезде The Walt Disney Company, Sony Pictures, Paramount Pictures, 20th Century Fox, Universal Studios Warner Bros, Netflix секілді ығай мен сығай кіретін Америка кинокомпаниялар қауымдастығы бұл ұсынысқа қарсы шыққан еді.

Кинематографтардың келтіріп отырған басты дәйегі — жаңа заң актерлар, музыканттар, атлеттер туралы өмірбаян түсіруді мүмкін емес етеді-мыс.

Deepfake — проблема, сөз жоқ. Бірақ оны сөз бостандығы мен шығармашылықты шектеу арқылы шешпеу керек, — деді сала өкілдері.

Кино әлемінің алпауыттарын түсінуге болады, себебі олар қайтыс болған белгілі актерлардың бейнесін экранға қайта алып кетуге, қартайған артистерді «жасартуға» мүдделі.

2004 жылы deepfake үлкен кинода бірінші рет қолданылды. 1989 жылы қайтыс болған Лоуренс Оливье «Аспан капитаны және болашақ әлемі» фильміне «түсті». Ал 2016 жылы «Жұлдызды соғыстар» сериясының кезекті бөлімі үшін 1994 жылы одүниелік болған Питер Кушингті киноға «оралды».

Ал «Терминатор: Генезисте» Арнольд Шварценеггер, бесінші «Кариб теңізі қарақшыларында» Джонни Депп осы технология арқылы «жасарып» шыға келді.

Қазір қаптаған кәсіподақтар болашақта актерлардың жұмыссыз қалмауы үшін жан-жақты күресіп жатыр. Себебі компьютерлердің қуаты артып, deepfake жаппай таралса, біраз актер ұсыныссыз қалуы мүмкін.

Әлем қандай шаралар қолданып жатыр?

Avast сарапшыларының бірі Луис Корронстың пікірінше, deepfake үлкен проблемаға айналады, оның шешімін табу да оңайға түспейді. Microsoft, Google, Facebook сияқты компаниялар сол шешімді іздеуге кірісіп кетті. Мәселен, былтырғы қыркүйек айында Facebook Deepfake Detection Challenge жариялады. Жүлде қоры 10 миллион доллар болатын бұл бәсекеде фейк видеоларды 100% танып-білетін бағдарлама ойлап тапқан адам жеңеді.

Жалған контентпен күресуде тыйым салу әдісі де қолданылып жатыр. Мәселен, 2019 жылдың қазан айында Калифорния штаты екі заң қабылдады. Бірі қандай да бір сайлауға 60 күн қалғанда осы мерзім ішінде саясаткерлердің бет-бейнесі бар фейк материалдар жасауға тыйым салады. Екіншісі порносайттардың кейіпкері болған азаматтарға фейк видео жасанған авторларға сотқа беруге жол ашады.

Бұдан бөлек, осы жылдан бастап Қытайда ескертпе қойылмаған deepfake фото немесе видео жариялауға тыйым салынды. Әу баста сөз болған Reddit те бірнеше күн бұрын ғана қолданушымен келісімді жаңартты. Енді кез келген сипаттағы жалған ақпарат жариялаған аккаунт бірден жойылады немесе банға кетеді. Сонымен бірге мемлекеттік органдар да fakeapp-facefake бағыттағы ресурстарды жаппай бұғаттауға көшті.

Қалай болғанда да трансұлттық компаниялар мен корпорациялар, дамыған және дамушы елдердің билігі бұл қатерді көріп отыр: қарапайым азаматтардың қауіпсіздігін ойламаса да (оны біз «желі гигиенасы» арқылы қамтамасыз етуіміз керек), өз мүддесі үшін заң-зәкүн, қарсы технологиялар түрінде шешімдер қабылдауға тиіс.